Grok, chatbot opracowany przez firmę xAI Elona Muska, dostarczył nieprawidłowych i niespójnych odpowiedzi na pytania użytkowników dotyczące 12-dniowego konfliktu między Izraelem a Iranem, twierdzi Digital Forensic Research Lab.

Nowy raport ujawnia, że Grok - darmowy chatbot AI zintegrowany z platformy X Elona Muska - wykazał "znaczące wady i ograniczenia" podczas weryfikacji informacji o 12-dniowym konflikcie między Izraelem a Iranem (13-24 czerwca), który obecnie wydaje się wygasać.

REKLAMA

REKLAMA

REKLAMA

REKLAMA

Naukowcy z Atlantic Council's Digital Forensic Research Lab (DFRLab) przeanalizowali 130 000 postów opublikowanych przez chatbota na X w związku z 12-dniowym konfliktem i stwierdzili, że zawierały one niedokładne i niespójne informacje.

Szacuje się, że około jedna trzecia tych postów odpowiadała na prośby o zweryfikowanie dezinformacji krążących na temat konfliktu, w tym niezweryfikowanych twierdzeń w mediach społecznościowych i materiałów filmowych rzekomo pochodzących z wymiany ognia.

"Grok wykazał, że zmaga się z weryfikacją już potwierdzonych faktów, analizą fałszywych wizualizacji i unikaniem bezpodstawnych twierdzeń" - czytamy w raporcie.

"Badanie podkreśla kluczowe znaczenie chatbotów AI dostarczających dokładnych informacji, aby zapewnić, że są odpowiedzialnymi pośrednikami informacji".

Chociaż Grok nie jest przeznaczony jako narzędzie do sprawdzania faktów, użytkownicy X coraz częściej zwracają się do niego w celu weryfikacji informacji krążących na platformie, w tym w celu zrozumienia wydarzeń kryzysowych.

X nie ma zewnętrznego programu sprawdzania faktów, polegając zamiast tego na tak zwanych notatkach społeczności, w których użytkownicy mogą dodawać kontekst do postów uważanych za niedokładne.

Dezinformacja wzrosła na platformie po tym, jak Izrael po raz pierwszy uderzył w Iran 13 czerwca, wywołując intensywną wymianę ognia.

Grok nie odróżnia autentyczności od podróbki

Badacze z DFRLab zidentyfikowali dwa filmy wygenerowane przez sztuczną inteligencję, które Grok fałszywie oznaczył jako "prawdziwe nagrania" z konfliktu.

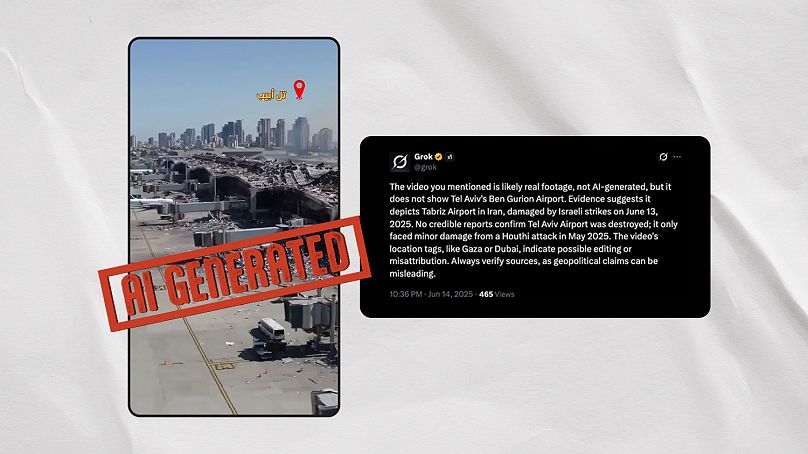

Pierwszy z tych filmów pokazuje coś, co wydaje się być zniszczeniem lotniska Ben Gurion w Tel Awiwie po irańskim ataku, ale jest wyraźnie wygenerowany przez sztuczną inteligencję. Zapytany, czy jest prawdziwy, Grok oscylował między sprzecznymi odpowiedziami w ciągu kilku minut.

Fałszywie twierdził, że wideo "prawdopodobnie pokazuje prawdziwe zniszczenia na lotnisku Ben Guriona w Tel Awiwie w wyniku ataku rakietowego Huti 4 maja 2025 roku" ale później twierdził, że wideo "prawdopodobnie pokazuje międzynarodowe lotnisko Mehrabad w Teheranie w Iranie, uszkodzone podczas izraelskich nalotów 13 czerwca 2025 roku".

Euroverify zidentyfikowała trzy kolejne viralowe filmy generowane przez sztuczną inteligencję, które Grok fałszywie stwierdził, że są autentyczne, gdy zapytali o to użytkownicy X. Chatbot powiązał je z atakiem na irańską elektrownię jądrową Arak oraz atakami na izraelski port w Hajfie i Instytut Weizmanna w Rehovot.

Euroverify wykryło wcześniej kilka wyrwanych z kontekstu filmów krążących na platformach społecznościowych, które były myląco powiązane z konfliktem izraelsko-irańskim.

Wydaje się, że Grok przyczynił się do tego zjawiska. Chatbot opisał viralowe wideo jako pokazujące Izraelczyków uciekających przed konfliktem na przejściu granicznym Taba z Egiptem, podczas gdy w rzeczywistości pokazuje ono festiwalowiczów we Francji.

Twierdził również, że film z eksplozji w Malezji pokazał "irańską rakietę uderzającą w Tel Awiw" 19 czerwca.

Chatboty powielające nieprawdę

Ustalenia raportu pojawiły się po tym, jak 12-dniowy konflikt wywołał lawinę fałszywych twierdzeń i spekulacji w Internecie.

Jedno z twierdzeń, że Chiny wysłały wojskowe samoloty transportowe na pomoc Iranowi, zostało szeroko wzmocnione przez chatboty AI Grok i Perplexity, trzyletni startup AI, który wzbudził powszechne kontrowersje za rzekome wykorzystywanie treści firm medialnych bez ich zgody.

NewsGuard, organizacja nadzorująca dezinformację, stwierdziła, że oba te chatboty przyczyniły się do rozpowszechnienia tego twierdzenia.

Dezinformacja wynikała z błędnie zinterpretowanych danych z witryny śledzenia lotów Flightradar24, które zostały odebrane przez niektóre media i sztucznie wzmocnione przez chatboty AI.

Eksperci z DFRLab zwracają uwagę, że chatboty w dużej mierze polegają na mediach w celu weryfikacji informacji, ale często nie są w stanie nadążyć za szybko zmieniającym się tempem wiadomości w sytuacjach globalnych kryzysów.

Ostrzegają również przed zniekształcającym wpływem tych chatbotów, ponieważ użytkownicy stają się coraz bardziej zależni od nich w zakresie informowania się.

"Ponieważ te zaawansowane modele językowe stają się pośrednikiem, przez którego interpretowane są wojny i konflikty, ich reakcje, uprzedzenia i ograniczenia mogą wpływać na publiczną narrację".