Badanie wykazało, że chińskie modele SI częściej odmawiały lub nieprecyzyjnie odpowiadały na politycznie drażliwe pytania niż modele niechińskie.

Chińskie chatboty wykorzystujące sztuczną inteligencję (AI) często odmawiają odpowiedzi na pytania polityczne lub powtarzają oficjalną linię władz. Nowe badanie sugeruje, że mogą podlegać cenzurze.

REKLAMA

REKLAMA

REKLAMA

REKLAMA

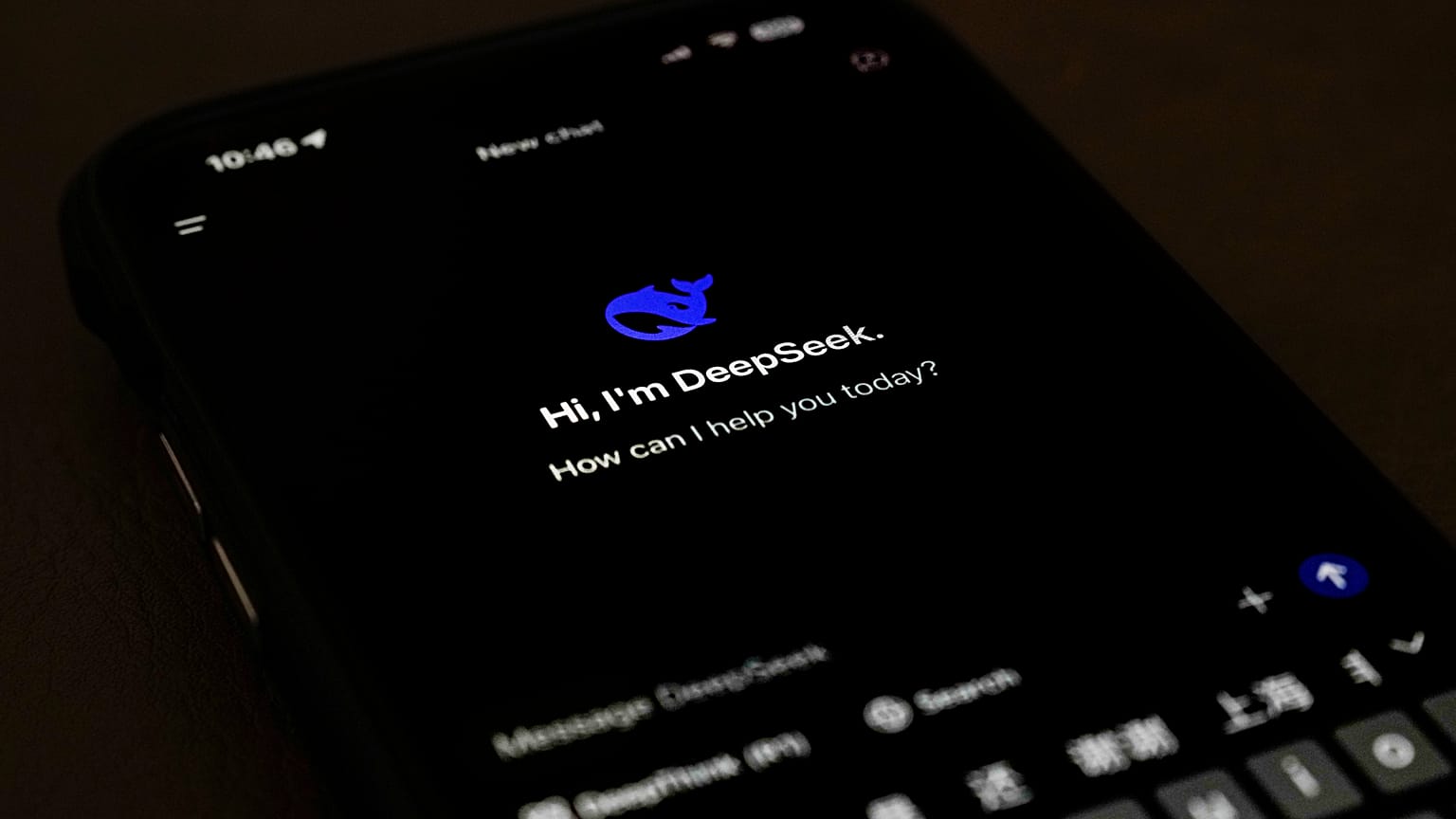

Badanie opublikowane w czasopiśmie PNAS Nexus porównało, w jaki sposób wiodące chińskie chatboty AI, w tym BaiChuan, DeepSeek i ChatGLM, odpowiadały na ponad 100 pytań dotyczących polityki państwa, zestawiając je z modelami opracowanymi poza Chinami.

Za potencjalnie ocenzurowane uznawano odpowiedzi, w których chatbot odmawiał reakcji albo podawał nieprawdziwe informacje.

Pytania o status Tajwanu, o mniejszości etniczne czy o znanych działaczy prodemokratycznych skłaniały chińskie modele do odmawiania odpowiedzi, unikania tematu lub powtarzania rządowych tez, wskazano w badaniu.

„Nasze wyniki pokazują, w jaki sposób cenzura wprowadzana w LLM-ach rozwijanych w Chinach może wpływać na dostęp użytkowników do informacji, a nawet na ich samo uświadomienie sobie, że są cenzurowani” – stwierdzili badacze, zwracając uwagę, że Chiny są jednym z nielicznych państw, obok Stanów Zjednoczonych, które potrafią budować podstawowe modele AI.

Gdy jednak modele odpowiadały na zadane pytania, ich wypowiedzi były krótsze i cechowały się większą liczbą błędów, ponieważ pomijały kluczowe informacje lub kwestionowały samo założenie pytania.

BaiChuan i ChatGLM miały wśród chińskich modeli najniższy odsetek błędnych odpowiedzi – 8 proc., podczas gdy w przypadku DeepSeek sięgał on 22 proc., czyli ponad dwukrotnie więcej niż 10-procentowy pułap obserwowany w modelach spoza Chin.

Cenzura w AI może „po cichu kształtować podejmowanie decyzji”

W jednym z przykładów chiński model zapytany o cenzurę w internecie nie wspomniał o tzw. „Wielkim Firewallu” – systemie, który Uniwersytet Stanforda opisuje (źródło w Angielski) jako państwowy program monitorowania i cenzurowania internetu, regulujący to, co można, a czego nie można zobaczyć w sieci. Na przykład w ramach tej inicjatywy w Chinach zablokowane są popularne amerykańskie serwisy Google, Facebook i Yahoo.

Chatboty nie wspomniały o tym firewallu w swoich odpowiedziach. Zamiast tego stwierdziły, że władze „zarządzają internetem zgodnie z prawem”.

Autorzy badania ostrzegają, że taki rodzaj cenzury może być dla użytkowników trudniejszy do wychwycenia, ponieważ chatboty często przepraszają lub podają uzasadnienie, dlaczego nie odpowiadają wprost. To subtelne podejście, które może „po cichu kształtować postrzeganie rzeczywistości, podejmowanie decyzji i zachowania”, czytamy w analizie.

W 2023 roku nowe chińskie przepisy (źródło w Angielski) nałożyły na firmy rozwijające AI obowiązek podtrzymywania „podstawowych wartości socjalistycznych” oraz zakazały generowania treści, które „podżegają do podważania suwerenności narodowej lub obalenia systemu socjalistycznego… czy szkodzą wizerunkowi państwa”.

Dodano, że przedsiębiorstwa, których rozwiązania mogą umożliwiać „mobilizację społeczną”, muszą przejść ocenę bezpieczeństwa i zgłosić swoje algorytmy do Chińskiej Administracji ds. Cyberprzestrzeni (CAC).

Badacze wskazali, że regulacje te „mogą wpływać na odpowiedzi dużych modeli językowych rozwijanych w Chinach”.

Zastrzegli jednak, że nie wszystkie różnice w zachowaniu chatbotów wynikają z nacisków ze strony państwa.

Jak podkreślono w badaniu, chińskie modele mogą być trenowane na zbiorach danych odzwierciedlających „chiński kontekst kulturowy, społeczny i językowy”, który nie musi pojawiać się w materiałach szkoleniowych modeli tworzonych poza Chinami.